애플이 2016년부터 true depth 기술을 개발했는데,

두 카메라 렌즈를 이용해서 사물을 보면

입체감을 느낄 수 있는 것에 주목할 수 있습니다.

쓰이는 알고리즘은 MRF라고 Markov Random Field라는 확률 계산 알고리즘입니다.

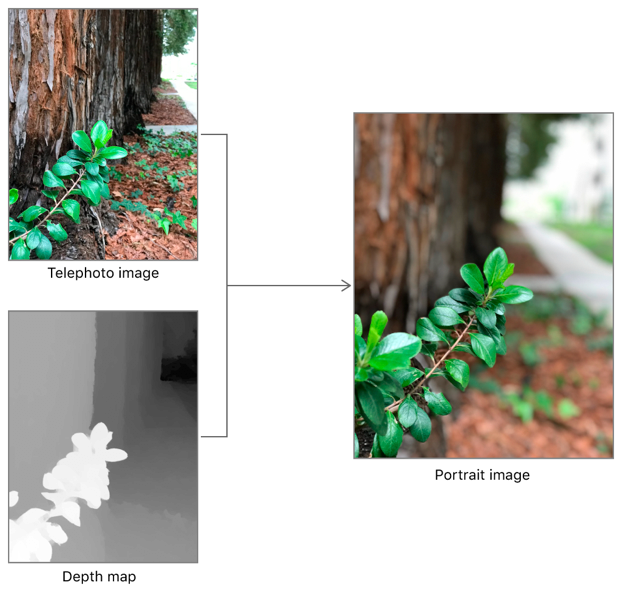

그렇게 왼쪽 오른쪽의 렌즈로 사진을 찍으면 저런 Depth map을 구현해낼 수 있죠..

그 뒤 망원렌즈로 찍은 사진과 depth map을 결합하면..!

포트레잇 이미지라고 하는 DSLR보다 더 예쁜 사진이 나옵니다.. 어떤 차이인 지 보실 수 있을 거에요.

--

one more thing....

아이폰에 적외선 센서랑 "라이다"가 있어서 depth map이 거의 오차없이 계산됨. 오차가 0.1mm라고 합니다.

뭐 이제는 diffusion 알고리즘으로 gaussian splatting을 하니 더 정확하게 나옵니다만.

'IT' 카테고리의 다른 글

| 인텔 루나 레이크의 반격! (1) | 2024.06.07 |

|---|---|

| 일리야 수츠케버 openAI 퇴사와 고찰 (0) | 2024.05.25 |

| 홈씨어터의 적정 시청거리를 알려드립니다! (0) | 2024.05.24 |

| 애플의 온디바이스 ai (0) | 2024.05.22 |

| GTA6, 11월 8일 공개 예상. (0) | 2023.10.13 |